本文目录导读:

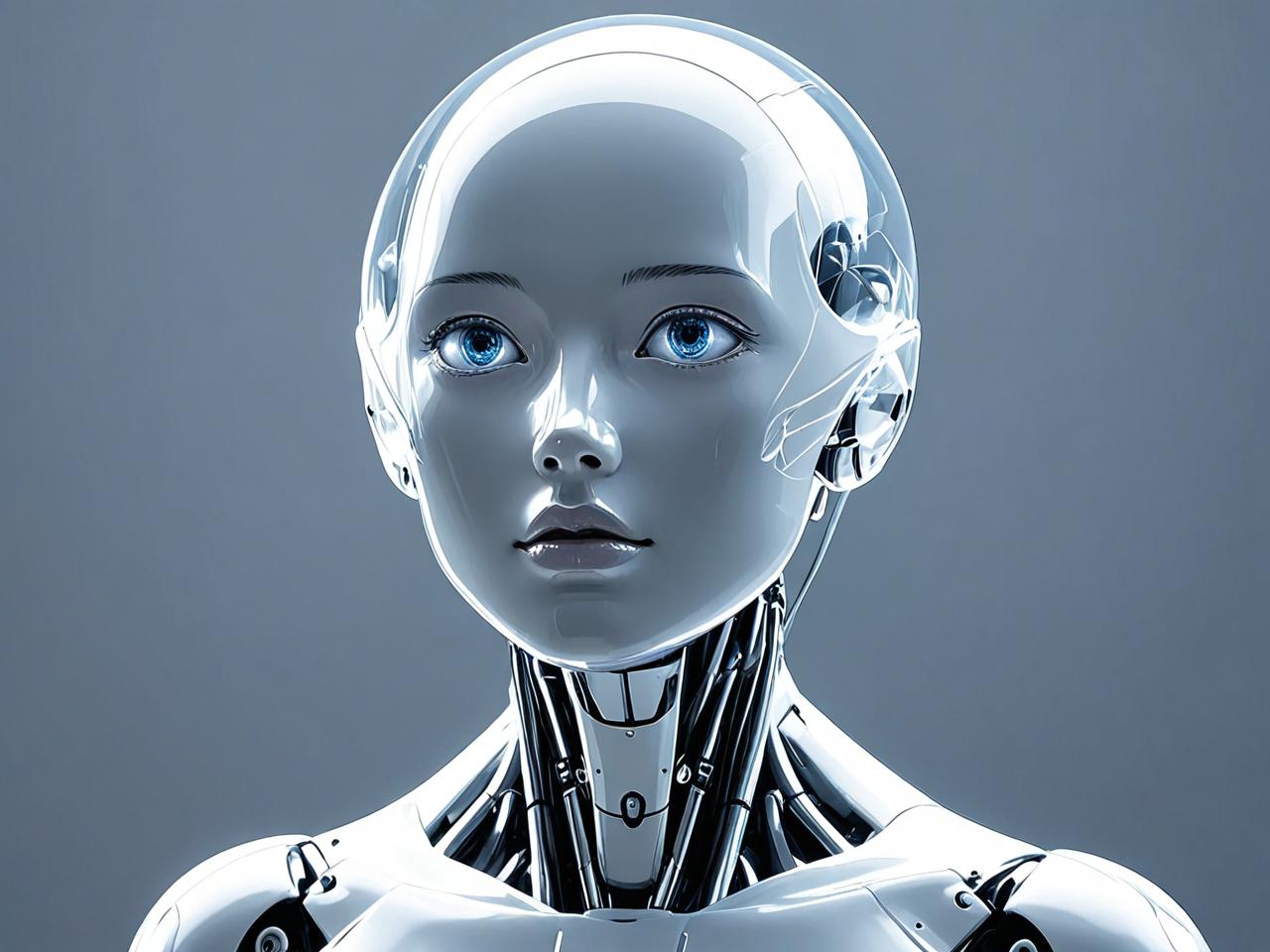

近年来,人工智能(AI)技术迅猛发展,已广泛应用于医疗、金融、自动驾驶、司法决策等领域,随着AI系统影响力的扩大,其决策过程的“黑箱”特性引发了广泛担忧,AI透明性(AI Transparency)因此成为学术界、产业界和政策制定者关注的焦点,透明性不仅是技术问题,更涉及伦理、法律和社会信任,本文将探讨AI透明性的定义、重要性、实现路径及未来挑战。

AI透明性的定义

AI透明性指人工智能系统的决策过程、数据来源、算法逻辑以及潜在偏见能够被人类理解、解释和审查的程度,透明性可分为三个层次:

- 技术透明性:算法的工作原理是否可被开发者或专家理解。

- 过程透明性:AI系统的训练数据、参数调整和优化过程是否可追溯。

- 结果透明性:AI的决策结果是否可解释,用户能否理解其推理路径。

在医疗诊断AI中,透明性意味着医生和患者能够知道AI为何推荐某种治疗方案,而非盲目接受其结论。

AI透明性的重要性

增强用户信任

如果AI系统无法解释其决策逻辑,用户可能对其产生不信任感,银行拒绝贷款申请时,若AI无法提供具体原因,客户可能认为存在歧视或不公,透明性有助于建立用户对AI的信任,促进技术普及。

确保公平性与减少偏见

AI系统可能因训练数据偏差而产生歧视性决策,招聘AI可能因历史数据中的性别偏见而倾向于选择男性候选人,透明性使开发者能够检测并修正这些偏见,确保AI的公平性。

法律合规与责任归属

随着《欧盟人工智能法案》(EU AI Act)等法规出台,AI透明性成为法律要求,当AI决策导致事故(如自动驾驶车祸)时,透明性有助于明确责任归属,避免法律纠纷。

促进技术创新

透明性鼓励开源协作,使研究者能审查和改进现有AI模型,GPT等大语言模型的透明度问题引发争议,部分企业选择公开部分训练数据以增强可信度。

实现AI透明性的路径

可解释AI(XAI)技术

可解释AI(Explainable AI, XAI)旨在使AI决策过程对人类更易理解。

- 局部可解释模型(LIME):通过模拟输入数据的小范围变化,解释AI的决策依据。

- 注意力机制(Attention Mechanism):在自然语言处理中,可视化AI关注的关键词,提高可解释性。

数据溯源与开放数据集

AI透明性依赖于高质量、可追溯的数据,企业应公开数据收集方式、清洗过程及潜在偏差,如IBM的AI Fairness 360工具包可帮助检测数据偏见。

标准化与政策监管

政府和行业组织需制定透明性标准,如IEEE的《伦理对齐设计指南》要求AI系统提供决策解释,欧盟的《通用数据保护条例》(GDPR)也赋予用户“算法解释权”。

用户教育与交互设计

即使AI系统具备透明性,普通用户仍可能难以理解技术细节,交互设计应提供直观的解释方式,如可视化图表、自然语言描述等。

AI透明性面临的挑战

性能与透明性的权衡

复杂AI模型(如深度神经网络)往往在透明性上表现较差,但简化模型可能降低准确性,如何在性能与可解释性之间平衡仍是难题。

商业机密与透明度冲突

企业可能不愿公开AI核心算法以避免竞争风险,如何在保护知识产权的同时提高透明度,需要政策与行业共识。

跨学科协作需求

AI透明性涉及计算机科学、伦理学、法学等多个领域,需加强跨学科合作以制定全面解决方案。

未来展望

AI透明性不仅是技术问题,更是社会议题,随着XAI技术的发展、政策法规完善以及公众认知提升,AI系统将逐步从“黑箱”走向“玻璃箱”,透明性将成为AI可持续发展的核心要素,确保技术真正服务于人类福祉。

AI透明性是构建可信赖人工智能的基石,只有通过技术创新、政策规范和社会协作,才能实现AI的公平、可靠与可持续发展,在AI日益渗透日常生活的今天,透明性不仅关乎技术伦理,更关乎人类未来的命运。